Czym tak naprawdę są OOT i jak je efektywnie wykrywać?

Brak naturalnego trendu

Na koniec rozważmy najprostszy przypadek, czyli taki, w którym parametr nie powinien zmieniać się w czasie, natomiast jego zmienność wynika z błędów pomiarowych i różnych fluktuacji procesowych, z którymi musimy się po prostu pogodzić. Takim narzędziem, o ugruntowanej pozycji, do odróżniania przyczyn losowych (zmienność wynikająca np. z błędu standardowego metody pomiarowej) od przyczyn istotnych (zły produkt, błąd pomiaru), które określamy jako OOT, jest karta kontrolna. Ma ona dwie zalety, które nie są bez znaczenia w codziennej pracy: prostotę tworzenia analizy i łatwość interpretacji wyników.

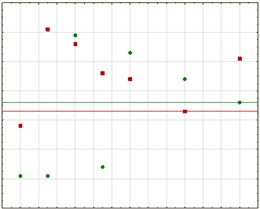

W przypadku tego typu danych możemy też podjąć się oceny różnicy położenia wartości średnich. Otrzymując każdy kolejny wynik, wyznaczamy narastająco wartość średnią i oceniamy, czy pomiędzy nią, a wartością średnią wzorca występuje statystycznie istotna różnica która będzie równoznaczna z OOT [rys. 6]. Do tego celu możemy wykorzystać standardowy test statystyczny oparty np. na rozkładzie t-Studenta.

Rys. 6. Wykrywanie różnicy przeciętnych wartości

Praktyczne rozwiązanie nietypowych zagadnień

Na tym etapie wiemy już jakie są wzorce, do których powinniśmy porównywać nowe wyniki oraz znamy techniki i kryteria identyfikacji OOT. Na tej podstawie możemy do każdego parametru przypisać odpowiednie zestawy warunków, według których ma być oceniany.

Teraz dochodzimy do kluczowego zagadnienia, które zamienia podejście retrospektywne na takie, które pozwala oceniać sytuację na bieżąco. Naszym celem jest przecież wykrywanie niepożądanych zjawisk w momencie ich wystąpienia, co pozwoli na podjęcie odpowiednich działań, a nie stwierdzenie faktu zaistnienia OOT i to po upływie dłuższego okresu czasu (co najczęściej ma miejsce podczas zestawiania danych na potrzeby rocznego przeglądu jakości).

W tym celu potrzebujemy kilku współpracujących ze sobą elementów, stanowiących jedno kompleksowe rozwiązanie informatyczne.

Dedykowane dla sektora farmaceutycznego i dostosowywane do potrzeb klientów systemy informatyczne w tym obszarze dostarcza firma DataComplex (www.datacomplex.pl), której eksperci posiadają prawie 15 letnie doświadczenie w opracowywaniu i wdrażaniu systemów IT w obszarze gromadzenia i analizy danych w farmacji.

Pierwszym elementem, którego „nie widać”, ale który jest fundamentem, to baza danych. Przechowywane są w niej dane historyczne (potrzebne do wyznaczania wzorców), metadane (opisujące znaczenie i charakterystyki parametrów), wzorce (z którymi porównywane będą nowe wartości) oraz na bieżąco gromadzone wyniki badań surowców, półproduktów, produktów gotowych, środowiska oraz parametrów procesu produkcji (które będą poddane monitoringowi i analizie trendów). Baza danych, oprócz przechowywania danych, zapewnia ich rzetelność i spójność oraz przechowuje je w układzie umożliwiającym tworzenie analiz, zestawień i raportów w dowolnych przekrojach.

Drugi element to zasilanie bazy nowymi wartościami wyników badań i parametrów procesu. Część informacji może być automatycznie pobierana z już istniejących systemów skomputeryzowanych (typu LIMS, ERP czy MES) lub z plikowych źródeł danych. Wyniki mogą być również wprowadzane przez pracowników technologicznych lub w laboratorium i dlatego potrzebny jest również wygodny interfejs ręcznego wprowadzania danych. Tutaj od razu dochodzimy do funkcjonalności analitycznej, ponieważ osoba wprowadzająca kolejne pomiary powinna od razy otrzymać informację zwrotną oceniającą dany wynik i system powinien automatycznie porównać go z zaimplementowanymi wzorcami i w razie wystąpienia OOT natychmiast o tym poinformować. W takim przypadku ważne jest też, aby taka osoba mogła w prosty sposób (korzystając z narzędzi analitycznych) zobaczyć wyniki analizy trendu dla takiego parametru i na tej podstawie ocenić sytuację. Nie wymagajmy jednak, aby pracownik laboratorium, który świetnie zna techniki analityczne był jednocześnie specjalistą statystykiem. Przy aktualnym rozwoju technologii informatycznych tego typu zadania są realizowane automatycznie przez odpowiednie, dedykowane rozwiązania a praca z nimi ogranicza się jedynie do przejrzenia danych i oceny dostarczonych kompleksowych i skomentowanych wyników analiz statystycznych.

Rzeczywiście, posiadając odpowiednie rozwiązanie informatyczne łatwo wyobrazić sobie sytuację, że osoba, która na co dzień zajmuje się badaniami jakiegoś parametru, wprowadza jego wyniki i na bieżąco otrzymuje informację zwrotną z oceną istnienia ewentualnego OOT. Nie jest natomiast powiedziane, że analiza trendów jest obowiązkiem tej właśnie osoby i trudno też jej będzie ocenić, co dzieje się z pozostałymi parametrami, seriami i produktami.

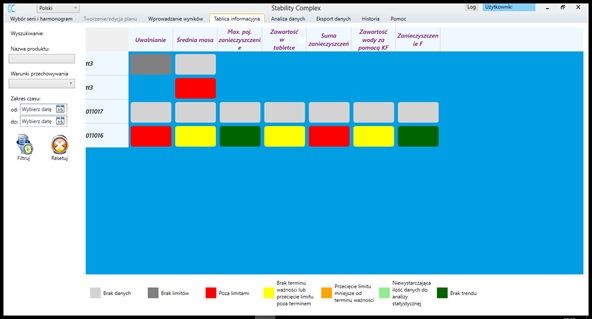

Znów przydatne okazują się rozwiązania, od dawna już stosowane w przemyśle produkcyjnym – syntetyczne tablice informacyjne. Przy pomocy jednego pulpitu możemy obserwować aktualną ocenę poszczególnych parametrów dla wszystkich serii produktu lub też dla wszystkich parametrów i produktów [rys. 7]. Zasada działania opiera się na wizualizacji (zazwyczaj w postaci kolorowych kafelków) wyników różnorodnych testów i ocen przeprowadzanych automatycznie przez system. W ten sposób możemy się dowiedzieć, czy np. wszystkie badania zostały wykonane w terminie i czy wprowadzono wszystkie wymagane wyniki, czy istnieje ryzyko przekroczenia limitów przez dany parametr, czy w danych wstępuje trend, czy zidentyfikowano OOT i na podstawie którego kryterium. Przy wdrożeniu takiego rozwiązania należy zawsze dokładnie ustalić zakres i sposób prezentowania informacji na takiej tablicy, aby później użytkownik mógł łatwo ocenić sytuację, przeglądając najważniejsze komunikaty.

Rys.7 Przykładowa tablica informacyjna w rozwiązaniu StabilityComplex (www.datacomplex.pl)

Oprócz możliwości śledzenia on-line przebiegu parametrów, system na bieżąco zapisuje w bazie danych wprowadzane lub automatycznie pobierane wyniki badań oraz parametry procesu. Dlatego w każdym momencie może wykonać, zgodnie z zaimplementowanymi szablonami analizę, zestawienie lub raport. W ten sposób określając interesujący zakres informacji, można natychmiast otrzymać np. gotowy kompletny raport na potrzeby rocznego przeglądu jakości.

Ponieważ opisywane zagadnienie mocno wiąże obszary danych historycznych, bieżącego gromadzenia wyników i parametrów, wielowariantowego monitorowania on-line dużej ilości informacji z wykorzystaniem technik analizy danych, jedynie dedykowany system informatyczny jest w stanie spełnić te wszystkie role, oszczędzić ogromne ilości czasu, pozwolić spełnić wymogi stawiane przez przepisy oraz dodatkowo zwiększyć bezpieczeństwo produkowanych preparatów.

Fot. zasoby własne autorów; freeimages.com